Algorithmen verarschen

Wie lassen sich Algorithmen manipulieren?

Algorithmen können auf verschiedene Weise manipuliert werden, um bestimmte Ergebnisse zu erzielen oder das Verhalten von Benutzern zu beeinflussen. Hier sind einige Möglichkeiten, wie Algorithmen manipuliert werden können:

- Falsche Daten: Algorithmen arbeiten auf der Grundlage von Daten. Wenn die Daten, die einem Algorithmus zur Verfügung gestellt werden, falsch oder manipuliert sind, kann der Algorithmus zu falschen oder unerwünschten Ergebnissen führen. Durch die Einspeisung falscher Daten in einen Algorithmus kann dieser gezielt manipuliert werden.

- Bias: Algorithmen können auch durch Bias (Voreingenommenheit) manipuliert werden. Wenn ein Algorithmus bestimmte Gruppen oder Personen bevorzugt oder diskriminiert, können seine Ergebnisse verfälscht werden. Dies kann aufgrund von Verzerrungen in den zugrunde liegenden Daten, der Auswahl der Trainingsdaten oder der Implementierung des Algorithmus geschehen.

- Manipulation der Inputdaten: Durch Manipulation der Inputdaten können Algorithmen dazu gebracht werden, bestimmte Ergebnisse zu erzielen oder bestimmte Verhaltensweisen zu fördern. Beispielsweise können Algorithmen, die Produkte empfehlen, durch Manipulation der Inputdaten dazu gebracht werden, bestimmte Produkte oder Marken zu bevorzugen.

- Manipulation der Ausgabe: Algorithmen können auch durch Manipulation der Ausgabe beeinflusst werden. Dies kann durch das Hinzufügen oder Entfernen von Ergebnissen geschehen, um bestimmte Ergebnisse zu bevorzugen oder zu unterdrücken.

- Social Engineering: Durch Social Engineering kann das Verhalten von Benutzern manipuliert werden, um bestimmte Ergebnisse zu erzielen. Dies kann durch die Verwendung von Psychologie, wie beispielsweise durch die Verwendung von Trigger-Wörtern, erreicht werden, um eine gewünschte Reaktion auszulösen.

Es ist wichtig zu beachten, dass viele Algorithmen darauf ausgelegt sind, Manipulationen zu erkennen und zu verhindern. Es gibt auch Bemühungen, Algorithmen transparenter zu gestalten und sicherzustellen, dass sie fair und unvoreingenommen sind.

Oft können wir keine Garantie für die Leistung von tiefen neuronalen Netzen aussprechen

Pascal Frossard

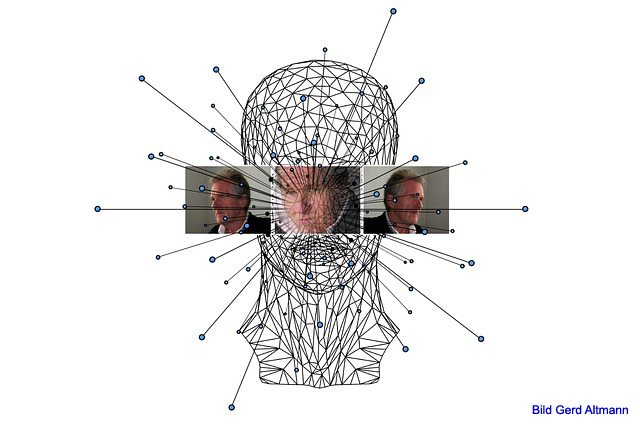

Adversarial Attacks

Adversarial Attacks sind eine Art von Angriffen auf maschinelle Lernmodelle, die darauf abzielen, deren Verhalten gezielt zu manipulieren, indem sie absichtlich kleine Änderungen an den Eingabedaten vornehmen. Diese Änderungen sind oft kaum wahrnehmbar für das menschliche Auge, können aber ausreichen, um das Modell dazu zu bringen, falsche Vorhersagen oder Entscheidungen zu treffen.

Adversarial Attacks sind eine ernsthafte Bedrohung für die Sicherheit und Verlässlichkeit von maschinellen Lernmodellen. Sie können aus verschiedenen Gründen durchgeführt werden, wie z.B. um die Ergebnisse von Bilderkennungs- oder Spracherkennungsmodellen zu beeinflussen oder um Sicherheitsmaßnahmen wie biometrische Authentifizierungssysteme zu umgehen.

Es gibt verschiedene Arten von Adversarial Attacks, darunter Gradienten-basierte Angriffe, die darauf abzielen, das Modell direkt zu manipulieren, und Black-Box-Angriffe, die versuchen, das Verhalten des Modells durch gezieltes Testen zu erlernen und auszunutzen. Es gibt auch Verteidigungsmaßnahmen, die entwickelt wurden, um maschinelle Lernmodelle vor Adversarial Attacks zu schützen, wie z.B. die Verwendung von robusten Modellen oder die Einführung von zufälligen Verzerrungen in die Eingabedaten, um die Angriffe zu erschweren.

White- oder Black-Box-Attacken

White-Box-Attacken und Black-Box-Attacken sind zwei verschiedene Arten von Angriffen auf maschinelle Lernmodelle im Zusammenhang mit Adversarial Attacks.

White-Box-Attacken werden auch als vollständig informierte Angriffe bezeichnet, da der Angreifer vollständigen Zugriff auf das Modell hat, einschließlich seiner Struktur, seiner Gewichte und seiner Trainingsdaten. Der Angreifer kann diese Informationen verwenden, um gezielte Angriffe durchzuführen, indem er gezielt Änderungen an den Eingabedaten vornimmt, um das Modell zu täuschen. White-Box-Attacken sind in der Regel sehr effektiv, da der Angreifer das Modell vollständig versteht und gezielt Schwachstellen ausnutzen kann.

Black-Box-Attacken hingegen sind weniger informierte Angriffe, da der Angreifer keinen Zugriff auf das Modell hat. Stattdessen versucht der Angreifer, das Verhalten des Modells zu lernen, indem er es mit verschiedenen Eingaben testet und beobachtet, wie es darauf reagiert. Basierend auf diesen Beobachtungen kann der Angreifer dann gezielte Angriffe durchführen, indem er Änderungen an den Eingabedaten vornimmt, um das Modell zu täuschen. Black-Box-Attacken sind in der Regel schwieriger durchzuführen als White-Box-Attacken, da der Angreifer das Modell nicht vollständig versteht.

Es ist wichtig zu beachten, dass beide Arten von Angriffen ernsthafte Bedrohungen für maschinelle Lernmodelle darstellen und dass es wichtig ist, Verteidigungsmaßnahmen zu ergreifen, um solche Angriffe zu verhindern. Dazu gehören beispielsweise robuste Modellarchitekturen und die Verwendung von Datenverzerrungen zur Erschwerung von Angriffen.

Deep Neural Networks (DNNs)

Deep Neural Networks (DNNs) sind künstliche neuronale Netzwerke mit mehreren Schichten (oder “Tiefen”), die in der Lage sind, komplexe Probleme zu lösen, indem sie Muster in großen Datenmengen erkennen und darauf basierend Vorhersagen treffen. DNNs sind eine Form des maschinellen Lernens, das sich auf neuronale Netzwerke stützt, um Muster in Daten zu erkennen und Vorhersagen zu treffen.

DNNs bestehen aus mehreren Schichten von Neuronen, die miteinander verbunden sind. Jede Schicht ist für die Verarbeitung bestimmter Arten von Informationen zuständig, die von der vorherigen Schicht übertragen werden. Die erste Schicht nimmt die Eingangsdaten auf und die letzte Schicht gibt die Ausgabe aus. Die Zwischenschichten sind oft als “versteckte Schichten” bezeichnet und dienen dazu, Merkmale oder Muster in den Eingabedaten zu extrahieren und zu lernen.

Ein wichtiger Vorteil von DNNs ist ihre Fähigkeit, automatisch Merkmale aus den Daten zu extrahieren, ohne dass der Benutzer diese manuell definieren muss. DNNs können auch große Datenmengen handhaben und komplexe Muster in den Daten erkennen, die von anderen Algorithmen möglicherweise übersehen werden.

DNNs werden in verschiedenen Anwendungen eingesetzt, darunter Bild- und Spracherkennung, Robotik, autonome Fahrzeuge, Finanzanalyse und vieles mehr.

Eingabe-Spoofing

Eingabe-Spoofing bezieht sich auf eine Methode, bei der das Modell eines Deep Neural Networks (DNNs) durch Einfügen von gefälschten oder manipulierten Eingaben dazu gebracht wird, falsche Vorhersagen zu treffen. Diese Methode kann verwendet werden, um die Stabilität und Zuverlässigkeit von DNNs zu testen oder um gezielt Angriffe auf das System durchzuführen.

Eingabe-Spoofing kann auf verschiedene Arten erfolgen. Zum Beispiel kann ein Angreifer versuchen, das DNN durch Einfügen von falschen oder manipulierten Datenpunkten zu täuschen. Diese Datenpunkte können so gestaltet sein, dass sie für menschliche Betrachter kaum von echten Daten zu unterscheiden sind, aber für das DNN eine signifikante Änderung der Vorhersage ergeben.

Ein weiteres Beispiel für Eingabe-Spoofing ist das Verändern von Eingabeparametern, um das Modell dazu zu bringen, falsche Vorhersagen zu treffen. Beispielsweise kann ein Angreifer durch Verändern von Bildparametern, wie Helligkeit, Kontrast oder Farbton, das DNN dazu bringen, eine falsche Bilderkennung auszuführen.

Eingabe-Spoofing ist ein potenzielles Sicherheitsrisiko, insbesondere in sicherheitskritischen Anwendungen wie autonomen Fahrzeugen, medizinischen Diagnosen oder Finanzvorhersagen. Entwickler von DNNs müssen geeignete Schutzmaßnahmen ergreifen, um solche Angriffe zu erkennen und zu verhindern, um die Sicherheit und Zuverlässigkeit von DNNs zu gewährleisten.

Explainable AI

Explainable AI (XAI) ist ein Ansatz in der künstlichen Intelligenz, bei dem das Ziel darin besteht, Modelle und Ergebnisse von Algorithmen so zu gestalten, dass sie für Menschen nachvollziehbar und verständlich sind. Im Gegensatz zu herkömmlichen Machine-Learning-Modellen, die oft als Black-Box-Systeme bezeichnet werden, die Ergebnisse liefern, ohne den internen Prozess zu offenbaren, soll XAI den internen Prozess der Entscheidungsfindung von Modellen transparent machen.

Die Idee hinter XAI ist es, die Entscheidungen, die von einem Algorithmus getroffen werden, zu verstehen, indem die Algorithmen auf eine Art und Weise entwickelt werden, dass ihre Entscheidungen durch eine Reihe von Regeln oder Faktoren erklärt werden können. Die Methode umfasst oft Visualisierungen, Dashboards und andere Tools, die den Nutzern helfen, das Verhalten des Algorithmus zu verstehen und Fehler zu erkennen.

XAI kann in vielen Bereichen eingesetzt werden, einschließlich medizinischer Diagnosen, Finanzprognosen, autonome Fahrzeuge und vieles mehr. Es ermöglicht nicht nur eine höhere Genauigkeit und Zuverlässigkeit, sondern auch ein besseres Verständnis der Daten und Entscheidungen, die durch die KI getroffen werden.

In der Praxis wird Explainable AI durch verschiedene Techniken realisiert, wie z.B. Entscheidungsregeln, Logik-basierte Modelle, Entscheidungs- und Informationsbäume, neuronale Aufmerksamkeitsmechanismen, saliency maps, Feature Importance, etc. Die Entscheidung darüber, welche XAI-Technik verwendet wird, hängt von der konkreten Anwendung, der Datenmenge und dem verwendeten KI-Modell ab.

Fazit zur Manipulation von Algorithmen

Die Manipulation von Algorithmen ist ein komplexes Thema mit vielen verschiedenen Aspekten. Es ist wichtig zu verstehen, dass Algorithmen nicht perfekt sind und es immer möglich ist, sie zu manipulieren oder zu täuschen. Die Folgen können weitreichend sein, von Fehlentscheidungen bis hin zu Sicherheitsrisiken in verschiedenen Anwendungsgebieten.

Adversarial Attacks, Eingabe-Spoofing und andere Manipulationsmethoden können dazu verwendet werden, um die Integrität von Algorithmen zu testen oder um gezielt Angriffe auf Systeme durchzuführen. Es ist wichtig, dass Entwickler und Anwender von Algorithmen geeignete Schutzmaßnahmen ergreifen, um diese Angriffe zu erkennen und zu verhindern.

Ein Ansatz, der dabei helfen kann, Algorithmen transparent und nachvollziehbar zu machen, ist Explainable AI (XAI). Dieser Ansatz zielt darauf ab, die Entscheidungsfindung von Algorithmen verständlicher und durchschaubarer zu gestalten, um das Vertrauen in die Entscheidungen zu stärken und potenzielle Fehler oder unerwünschte Auswirkungen aufzudecken.

Insgesamt ist es wichtig, sich bewusst zu sein, dass Algorithmen von Menschen entwickelt werden und auch von Menschen beeinflusst werden können. Eine offene und kritische Diskussion darüber, wie Algorithmen entwickelt werden und wie sie eingesetzt werden sollten, kann dazu beitragen, ihre Integrität und ihren Nutzen zu gewährleisten.

Zum Thema

Deep Neuronal Networks : Forscher tricksen Algorithmen aus, um sie besser zu verstehen